Stell dir vor: Deine Tochter ruft dich an – die Stimme klingt zumindest wie deine Tochter, die Schauspielerin Margot Robbie im neuen Barbie-Film trägt statt ihrem dein Gesicht und plötzlich taucht im Internet ein Video auf, das dich bei einer Straftat zeigt – du bist jedoch unschuldig und das Video ist eine perfide Fälschung. Willkommen in der Welt der Deepfakes, einer unsichtbaren Bedrohung, die unsere Realität manipuliert.

Mithilfe von KI-Bildgeneratoren wie Midjourney, DALL-E2 oder Stable Diffusion lassen sich täuschend echte Bilder erstellen sowie bestehende Bilder manipulieren, indem zum Beispiel Gegenstände hinzugefügt oder entfernt werden. Was als unterhaltsame Möglichkeit begann, nämlich Kunstwerke zu erstellen, hat sich zu einer gefährlichen Waffe entwickelt. Während der Papst im Rapper Mantel einem lediglich ein Grinsen ins Gesicht zaubert und zu Verwirrung führt, können Fake-Bilder von Rauch über dem Weißen Haus Panik auslösen. Solche Manipulationen können dazu führen, dass die Vertrauenswürdigkeit des Mediensystems angezweifelt oder auch elementare Prinzipien des Rechtssystems und der Demokratie untergraben werden.

Berichten zufolge fiel auch ein Vorstandsvorsitzender eines britischen Energieunternehmens auf Telefonbetrüger:innen herein und überwies eine hohe Summe an diese. Er ging davon aus, dass er mit seinem Chef, dem Vorstandsvorsitzenden der deutschen Muttergesellschaft, telefonierte. Die Stimme am Telefon hatte den gleichen deutschen Akzent und ähnelte der Stimme seines Chefs. Er bekam die Anweisung 220.000 Euro auf ein Bankkonto eines ungarischen Lieferanten zu überweisen. Diese führte er ohne zu zögern aus. Erst nachdem die Betrüger:innen nach einer Folgezahlung verlangten, wurde er misstrauisch und erkannte, dass er auf Betrüger:innen, die täuschend echt klangen, hereingefallen war. Das Geld war jedoch bereits überwiesen.

Die grausame Erfahrung, dass ihr Gesicht plötzlich in einem Pornofilm auftauchte, machte beispielsweise die Schauspielerin Kristen Bell. Das Gesicht einer Pornodarstellerin wurde durch ihres ersetzt. Da von Schauspielern und Prominenten zahlreiche Bilder im Internet zur Verfügung stehen, können solche Videomanipulationen mit hoher Qualität erstellt werden und somit sehr realistisch wirken.

Durch die Manipulation von medialen Inhalten mit Falschinformationen wird zunehmend das Vertrauen in die Realität untergraben. Doch wie können wir uns schützen, wenn sogar unsere Sinne getäuscht werden? Was ist dann noch authentisch?

Was sind Deepfakes?

Unter Deepfakes versteht man Verfahren, um mediale Identitäten zu manipulieren. Das Prinzip ist nicht neu und existiert bereits seit einigen Jahren. Schon längere Zeit war es möglich beispielsweise mit Adobe PhotoshopTM ein Bild zu bearbeiten und das Gesicht einer Person auszutauschen. Dies war jedoch zeitaufwendig und gewisse Fähigkeiten waren notwendig. Bereits 2018 entstand das “Obama Buzzfeed Deepfake” und weitere folgten.

Neu ist, dass die Manipulationen zunehmend täuschend echt aussehen und Fälschungen kaum zu erkennen sind. Dieser Fortschritt wurde durch den Einsatz Künstlicher Intelligenz erreicht. In diesem Zusammenhang wird von Deepfakes gesprochen. Der Name leitet sich von der Technologie Deep Learning, die zum Erstellen der Fakes eingesetzt wir, ab. Manipulationen sind mittlerweile nicht nur an Bildern und Texten möglich, sondern auch an dynamischen Medien, wie Videos und Audios. Durch den Einsatz von Künstlicher Intelligenz geht es nicht nur einfach und schnell, mediale Inhalte zu manipulieren, sondern die Fälschungen werden zudem in hoher Qualität erstellt. Heutzutage gibt es zahlreiche Onlinetools, die Manipulationen in sekundenschnelle vornehmen.

Die eingesetzten neuronalen Netze sind in der Lage, aus unstrukturierten Daten, wie dem menschlichen Gesicht oder der Stimme, wichtige Merkmale zu extrahieren und zu lernen. Zum Beispiel kann eine KI Daten über die Mimik des Gesichts sammeln. Nach der Erfassung dieser Daten können sie mit einem Generative Adversarial Network (GAN) verarbeitet werden, um beispielsweise ein Deepfake-Video zu generieren. Dabei handelt es sich um ein maschinelles Lernsystem, das aus zwei neuronalen Netzen besteht, die miteinander konkurrieren. Da eine solche Architektur ständig die generierten Daten mit echten Daten vergleicht, werden die gefälschten Daten immer besser und qualitativ hochwertiger. Die einzelnen Möglichkeiten zur Erstellung und Veränderung von medialen Inhalten schauen wir uns im Folgenden näher an.

Welche Arten von Deepfakes gibt es?

Fälschung von Gesichtern:

- Face Swapping: Beim Face Swapping wird das Gesicht einer im Bild / Video vorhandenen Person (Target) durch das Gesicht einer ausgewählten Person (Donor) ersetzt. Dabei werden Gesichtsausdruck, Gesichtsbeleuchtung und Blickrichtung wie im Original beibehalten. Dies wird zum Beispiel durch Autoencoder erreicht, die die relevanten Informationen aus dem Gesichtsbild der im Video vorhandenen Person (Target) kodieren und extrahieren, um ein entsprechendes Gesichtsbild der ausgewählten Person (Donor) zu erstellen. Es wird nur wenig Bild- / Videomaterial der ausgewählten Person (Donor) benötigt, um das Modell zu trainieren. Dieses sollte jedoch möglichst unterschiedliche Mimiken und Perspektiven enthalten. FaceShifter, FaceSwap, TikTok oder Snapchat sind Anwendungen, die einen Gesichtstausch ermöglichen. Apps wie Snapchat oder TikTok benötigen deutlich weniger Rechenleistung, erzeugen dadurch aber auch Ergebnisse in deutlich schlechterer Qualität. Ein Gesichtstausch lässt sich hier jedoch in Echtzeit durchführen.

- Face Reenactment: Darunter wird verstanden, dass die Mimik, Kopfbewegung oder Lippenbewegung (Lip Syncing) einer Person in einem Video nach Wunsch kontrolliert und verändert werden kann. So können täuschend echte Videos erstellt werden, in denen die Person Handlungen ausführt oder Aussagen trifft, die sie in der Realität nie getroffen hat. Speziell beim Lip Syncing kann die Lippenbewegung in einem Video so auf eine Sprachaufnahme angepasst werden, dass es so aussieht, als würde die Person dies sagen. Umgesetzt werden kann das beispielsweise durch die Erzeugung eines 3D-Modells des Gesichts. Eine mögliche Anwendung um Lip Syncing vorzunehmen ist Wav2Lip.

- Außerdem lassen sich auch (Pseudo-) Identitäten synthetisieren, indem fiktive Personen erzeugt werden, die in der realen Welt nicht existieren.

Fälschung von Stimmen:

- Text-to-Speech (TTS): Bei einem Text-to-Speech-System (TTS) gibt der Benutzende einen Text vor, der vom TTS-System verarbeitet und in ein Audio-Signal umgewandelt wird. Das entstandene Audiosignal enthält den semantischen Inhalt des vorgegebenen Textes, während die sprecherspezifischen Merkmale idealerweise denjenigen einer spezifizierten Person entsprechen.

- Voice Conversion (VC): Bei einem Voice Conversion-System (VC) gibt der Benutzende ein Audiosignal vor, welches zu einem veränderten Audiosignal umgewandelt wird. Das neue Audiosignal enthält den semantischen Inhalt des vorgegebenen Ursprungssignals, während sich die zu hörende Charakteristik des Sprechers ändert. Diese gleicht der ausgewählten Person.

Fälschung von Texten:

- Die Methoden der Textfälschung sind vielschichtig und reichen von Umformulierungen und Kontextveränderungen bis hin zu manipulierten Zitaten. Diese Techniken ermöglichen es, Informationen zu verzerren und eine völlig neue Bedeutung zu suggerieren, die mit der ursprünglichen Intention nichts zu tun hat. Zusätzlich können auch lange zusammenhängende Texte von KI-Modellen geschrieben werden, die den Stil und die Thematik menschlicher Verfasser imitieren. Die Auswirkungen der Textfälschungen sind tiefgreifend und potenziell gefährlich. Politische Karrieren könnten gefährdet, Unternehmen geschädigt und das Vertrauen der Öffentlichkeit in die Medien untergraben werden. Wenn gefälschte Informationen als wahr akzeptiert werden, könnten Textfälschungen sogar zu sozialen Spannungen oder Konflikten führen. Ist dir aufgefallen, dass der vergangene Abschnitt zu “Fälschung von Texten” nicht von mir, sondern von ChatGPT geschrieben wurde?

Blind für die Täuschung: Die alarmierende Unwissenheit über Deepfakes

Problematisch ist, dass sich ein Großteil der Bevölkerung noch nicht der Gefahr bewusst ist, die Deepfakes mit sich bringen. Beängstigender Weise gaben bei einer Umfrage von iProov im Jahr 2022 71% der Befragten an, dass sie nicht wissen, was Deepfakes sind. In Deutschland sind Deepfakes sogar 75% der Befragten unbekannt.

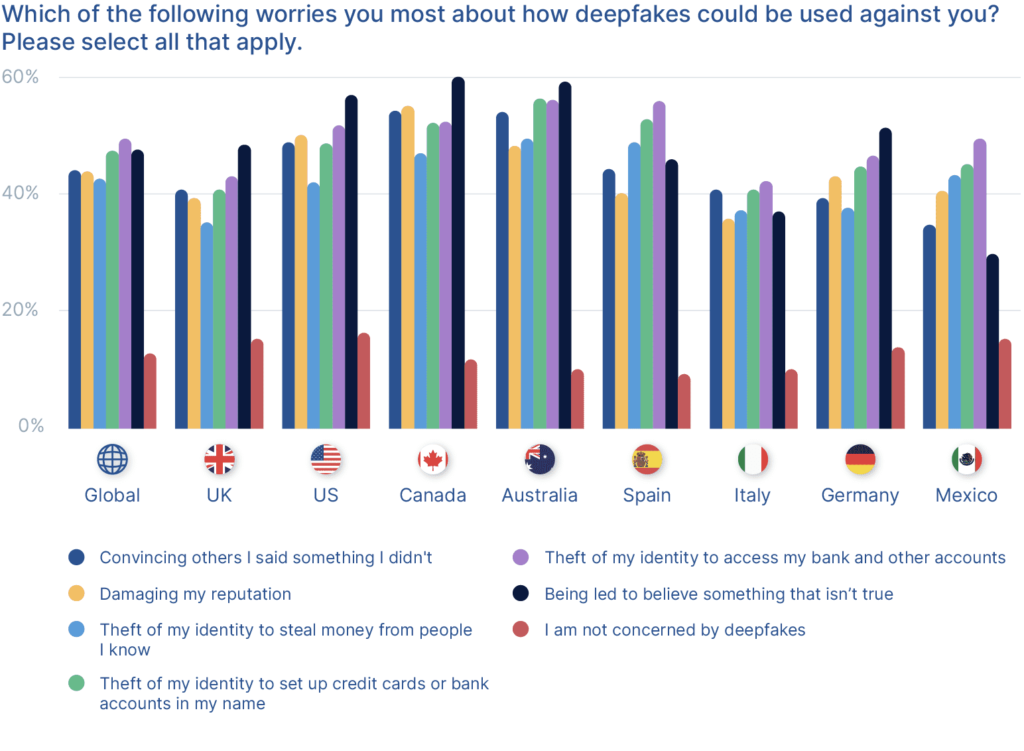

Vor den in der nachfolgenden Abbildung genannten Szenarien haben die Befragten im Zusammenhang mit Deepfakes am meisten Bedenken. Das gilt besonders für Diebstahl und Misstrauen. Nur 13% der Befragten nehmen an, dass sie nicht von Deepfakes betroffen sind.

„Mir passiert sowas nicht.“

Bereits von Kindern im Alter von 5 Jahren befinden sich durchschnittlich 1500 Bilder im Internet. Das geschieht, ohne dass das Kind diesem Upload selbst zustimmen konnte. Einerseits sind die Bilder eine schöne Erinnerung und Freunde und Bekannte freuen sich über die geteilten Bilder, aber andererseits bringen Eltern damit die Sicherheit und Privatsphäre ihres Kindes in Gefahr. Diese Bilder können unter anderem zum Beispiel für Hacking, Profiling oder Pädophilie missbraucht werden. In einem Spot „Nachricht von Ella“ möchte die Telekom AG darauf aufmerksam machen, welche Auswirkungen Sharenting haben kann.

Was ist von dir alles im Internet zu finden? Könnte der nächste Deepfake über dich sein?

Wie können wir uns vor Deepfakes schützen?

Wie aus den oben erwähnten Umfrageergebnissen hervorgeht, ist es besorgniserregend, dass viele Menschen nicht über die Gefahr von Deepfakes informiert sind. Ein erster und wichtiger Schritt ist es, möglichst viele Menschen aufzuklären. Einerseits sollten nur qualitativ hochwertige Nachrichtenquellen herangezogen werden, andererseits sollte jeder die Schwachstellen von Deepfakes kennen und wissen, wie man diese entlarven kann. Eine skeptische Haltung gegenüber Sprachnachrichten, E-Mails und Videos ist zwar keine Garantie dafür, dass du nicht getäuscht wirst, aber es können dadurch viele Angriffe vermieden werden.

Wie erkenne ich Deepfakes?

Einige Deepfakes weisen eine mindere Qualität auf und sind an Schwachstellen erkennbar. Es kann beispielsweise zu Problemen bei der Lippensynchronisation kommen oder der Hautton wirkt unregelmäßig. Feine Details, wie die Haare, stellen bei der Manipulation eine besondere Herausforderung dar, insbesondere wenn Strähnchen am Gesichtsrand sichtbar sind. Wichtig ist auch zu beachten, welche Quelle den medialen Inhalt veröffentlicht hat. Im Folgenden sind ein paar Tipps beziehungsweise Fragestellungen formuliert, die dabei helfen können, Deepfakes zu erkennen.

Ist ein Bild oder Video gefälscht?

- Sind im Bild / Video nur eventuell manipulierte Bereiche (z.B. Gesicht) besonders scharf oder unscharf?

- Ändert sich der Hautton am Gesichtsrand?

- Hat die Person ein Doppelkinn oder doppelte Augenbrauen?

- Blinzelt eine Person über eine längere Videosequenz nicht?

- Gibt es Veränderungen im Hintergrund oder der Beleuchtung (Perspektive)?

- Stimmt die Hintergrundszene mit dem Motiv im Vordergrund überein?

- Sind normalerweise scharfe Kanten wie bei Zähnen oder Augen unscharf?

Ist eine Audioaufnahme gefälscht?

- Wird in abgehackten Sätzen gesprochen?

- Ändert sich der Tonfall während der Aufnahme oder klingt die Aufnahme monoton?

- Stimmt die Phrasierung?

- Stimmt der Kontext der Audioaufnahme mit dem aktuellen Gespräch überein oder beantwortet dieser die aktuelle Frage nicht?

- Klingt die Aufnahme “metallisch”?

Ist ein Text gefälscht?

- Enthält dieser Grammatik- oder Rechtschreibfehler?

- Fehlt der Fluss im Satz / Text?

- Stammt der Text von einem unbekannten Absender (E-Mail-Adresse, Nummer)?

- Formuliert der Absender seine Texte üblicherweise in diesem Stil?

- Steht der Text im Kontext der aktuellen Diskussion?

Was bietet Schutz?

Da bereits heutzutage Deepfakes von Menschen nicht immer als solche identifiziert werden, ist die Frage, wie wir uns davor schützen können, umso wichtiger. Wie bereits erwähnt, ist ein wichtiges Gegenmittel, möglichst viele Personen darüber zu informieren, dass man Bescheid weiß, dass bei einem Telefonanruf nicht immer die erwartete Person am anderen Leitungsende ist, sondern dies auch Betrüger:innen sein können. Weiterhin schützen auch hier gängige Sicherheitsmechanismen, wie eine 2-Faktor-Authentifizierung oder sichere Passworte. Damit wird zum Beispiel dem Angreifenden der Zugang zu privaten Daten, die als Trainingsmaterial eingesetzt werden können, erschwert. Die 2-Faktor-Authentifizierung kann auch dabei helfen, bei erfolgreicher Umgehung des biometrischen Systems, Betrüger:innen dennoch keinen Zugriff zum angegriffenen System zu ermöglichen.

Um die Glaubhaftigkeit von demokratischen und medialen Institutionen zu stärken, ist es wichtig, dass die Authentizität der Daten geprüft werden kann. Dabei gibt es einige sich entwickelnde Technologien, um Daten wie Videos zu authentifizieren. Mithilfe von kryptografischen Algorithmen werden in bestimmten Abständen Hashes, beispielsweise in das Video, eingefügt. Versucht ein Angreifer dieses Video zu manipulieren, ändern sich die Hashes. Eine weitere Möglichkeit ist der Einsatz von KI und Blockchain. Dadurch kann ein fälschungssicherer digitaler Fußabdruck für Daten wie Videos registriert werden. Bei Videos besteht die Herausforderung, die Hashes zu erhalten, während das Video für die Verwendung mit unterschiedlichen Codecs komprimiert wird.

Letztendlich kann ironischerweise auch Künstliche Intelligenz als Gegenmaßnahme fungieren. So wie eine “bösartige” KI trainiert werden kann, um Deepfakes zu erstellen, kann auch eine “gute” KI trainiert werden, um diese zu identifizieren. Es besteht jedoch die Gefahr, dass die “gute” KI nur Deepfakes erkennt, wozu ähnliche Beispiele in den Trainingsdaten enthalten waren. Findet der Angreifer einen Weg, die “gute” KI zur Überprüfung von medialen Inhalten auszutricksen, muss diese erst wieder nachtrainiert werden. So hat beispielsweise die Überlagerung eines gefälschten Bildes mit leichtem Rauschen, das mit dem bloßem Auge nicht erkennbar ist, die “gute” KI davon abgehalten, ein Bild als Fake einzustufen.

Wohin könnte sich die Deepfake-Bedrohung in Zukunft entwickeln?

Mit zunehmend besserer Hardware können wir davon ausgehen, dass sich die Qualität von Deepfakes in Zukunft weiter verbessern wird. Es wird es damit nahezu unmöglich, Deepfakes mit bloßem Auge zu erkennen. Zudem wird für die Erstellung von Deepfakes vermutlich immer weniger Trainingsmaterial der geschädigten Person notwendig sein, wodurch die Gefahr steigt, dass jeder zum Angriffsziel werden könnte. Wer hat kein Profilbild in WhatsApp, Instagram oder LinkedIn welches in einem solchen Fall bereits als Trainingsmaterial dienen kann? Weiterhin wird es vermutlich immer schneller und einfacher möglich sein, Deepfakes zu erstellen, sodass qualitativ hochwertige Deepfakes sogar in Echtzeit generiert werden können.

Bereits im kleinen, privaten Rahmen können Deepfakes gefährlich werden, wie zum Beispiel beim Enkeltrick. Dies kann sogar noch gesteigert werden, indem ein Familienmitglied einen vermeintlichen Videoanruf über WhatsApp tätigt. Über die schlechte Qualität des Videoanrufs würde sich keiner Gedanken machen, da dies doch typisch für einen WhatsApp-Videoanruf sein kann. Würdest du etwa bei der Bitte von einem Familienangehörigen nach etwas Geld über einen WhatsApp-Videoanruf misstrauisch werden? Weiterhin könnten im Rahmen von Gerichtsstreitigkeiten Beweismittel gefälscht werden. “Ich war gestern Abend doch zuhause. – Ich habe sogar ein Bild, wie ich mit meiner Tochter auf der Couch sitze.”

Nachdem Elon Musk 2018 in einem Interview einen Joint rauchte, stürzte die Tesla-Aktie stark ab. Können Deepfakes kurzfristig die gleichen Reaktionen auslösen? Können dadurch Schwankungen am Aktienmarkt verursacht, Wähler manipuliert und Spannungen hervorgerufen werden? Kann ein Bild von Rauch über dem Weißen Haus Panik hervorrufen, die dann zu Staus, Unfällen und Gewalttaten führt?

Mögliche Angriffsziele stellen auch biometrische Systeme dar, insbesondere Verfahren wie Videoident oder Sprecherauthentifizierung über das Telefon. Ein Sicherheitsexperte des Computer Chaos Clubs überlistete selbst mit klassischen und einfachen Mitteln das Videoident-Verfahren. Dafür hielt er während dem Verfahren seinen eigenen Ausweis in der Hand und innerhalb weniger Sekunden ersetzte eine Software den Videoausschnitt des Ausweises mit einer vorbereiteten Fälschung. So schaffte er es bei mehreren Verfahren eine elektronische Patientenakte für fremde Personen anzulegen. Diese Verfahren haben die Schwäche, dass ihnen nur das Ausgangssignal zur Verfügung steht, diese jedoch keinen Zugriff auf das Mikrofon oder die Kamera beziehungsweise deren Datenstrom haben und somit keine Veränderungen am aufgezeichneten Material feststellen können.

Die Sorge vor der Überlistung von biometrischen Systemen wird auch durch ein Paper bestätigt, in dem ein neuronales Netzwerk entwickelt wurde, das “Master Faces” generieren kann, um biometrische Systeme zu umgehen. Bei “Master Faces” handelt es sich um durchschnittlich wirkende Gesichtsbilder, die als Universalschlüssel eingesetzt werden können, da sie für mehrere Identitäten gültig sind und somit die Sicherheitsbarriere umgehen können. Das Ergebnis der Arbeit war, dass für mehr als 40 Prozent der Gesellschaft insgesamt neun “Master Faces” ausreichen, um die getesteten biometrische Systeme zu umgehen. Jedoch wurden die Ergebnisse der Arbeit teilweise in Frage gestellt‚ da der verwendete Datensatz hauptsächlich männliche Personen enthält, ethische Minderheiten weniger vertreten sind und auch nur eine begrenzte Altersgruppe enthalten ist. Noch ist die Gefahr nicht real, aber es stellt sich berechtigterweise die Frage, ob es früher oder später eine KI geben wird, die in der Lage ist, biometrische Systeme zu umgehen?

Falls wir als Gesellschaft nicht bald handeln und Möglichkeiten finden die Glaubwürdigkeit von Informationen zu garantieren und Deepfakes zu verhindern‚ gehen ich davon aus, dass es zu einem Wettrennen zwischen einer “guten” KI, die Deepfakes identifiziert und einer “bösen” KI, die Deepfakes generiert, kommen wird. Vielleicht wird der Mensch schon bald nicht mehr in der Lage sein, eigenständig zu unterscheiden, ob etwas echt oder fake ist? Möchte ich dann zu einem System greifen, dass auf der gleichen Technologie basiert und plötzlich gut sein soll? Woher weiß ich, dass dieses System mich nicht auch betrügt? Sind KI´s bald in der Lage mehr zu können als Menschen und werden wir von diesen untergraben?

Quellen und weiterführende Informationen:

- Telekom AG – “ShareWithCare”-Kampagne: https://www.telekom.com/de/konzern/details/share-with-care-1041638

- BSI – Deepfakes – Gefahren und Gegenmaßnahmen: https://www.bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Informationen-und-Empfehlungen/Kuenstliche-Intelligenz/Deepfakes/deepfakes_node.html

- Deepfakes: https://www.dhs.gov/sites/default/files/publications/increasing_threats_of_deepfake_identities_0.pdf

- Umfrageergebnisse: https://www.iproov.com/blog/deepfakes-statistics-solutions-biometric-protection

- Kaspersky – Wie schütze ich mich?: https://www.kaspersky.com/resource-center/threats/protect-yourself-from-deep-fake

- CEO wird um 220.000€ betrogen: https://www.forbes.com/sites/jessedamiani/2019/09/03/a-voice-deepfake-was-used-to-scam-a-ceo-out-of-243000/?sh=69269fa72241

- Enkeltrick: https://www.ndr.de/ratgeber/verbraucher/Deepfakes-Wenn-Betrueger-die-KI-fuer-den-Enkeltrick-nutzen,enkeltrickki100.html

- Kristen Bell – Deepfakes in Pornografie: https://www.insider.com/kristen-bell-face-pornographic-deepfake-video-response-2020-6

- Papst im Rapper Mantel: https://prmagazin.de/deep-fake-revolution/

- Generating Master Faces for Dictionary Attacks with a Network-Assisted Latent Space Evolution: https://arxiv.org/pdf/2108.01077.pdf

- Generalsschlüssel für Systeme zur Gesichtserkennung: https://www.heise.de/news/Forscher-entdecken-Generalschluessel-fuer-Systeme-zur-Gesichtserkennung-6156605.html

- Kritik an Paper zu Master Faces: https://www.unite.ai/master-faces-that-can-bypass-over-40-of-facial-id-authentication-systems/

- Überlistung von Video Ident mit klassischen Ansätzen: https://www.zeit.de/digital/datenschutz/2022-08/videoident-verfahren-online-identitaetsnachweis-ausweis-risiken?utm_referrer=https%3A%2F%2Fwww.google.com%2F

Leave a Reply

You must be logged in to post a comment.