Dieser Blogpost wurde für das Modul Enterprise IT (113601a) verfasst.

Einleitung: Das Ende der manuellen Abwehr

Wer heute in einem Security Operations Center (SOC) arbeitet, steht oft vor einer schier unbezwingbaren Wand aus Daten. Es ist längst kein Geheimnis mehr: Die schiere Masse, das Tempo und vor allem die Raffinesse moderner Cyberangriffe haben unsere klassischen, regelbasierten Abwehrsysteme schlichtweg überholt. Analysten kämpfen täglich mit einer regelrechten Flut von über 10.000 Warnmeldungen. Das führt zu einer gefährlichen „Alert Fatigue“, einer Alarm-Müdigkeit, bei der kritische Bedrohungen im ständigen Grundrauschen untergehen können.

Genau hier setzt das AI-Augmented SOC an. Es geht nicht darum, den Menschen zu ersetzen, sondern ihn durch den Einsatz von KI massiv zu entlasten. Durch die intelligente Vorfilterung werden Reaktionszeiten verkürzt, Fehlalarme drastisch reduziert und am Ende nicht nur die Sicherheit erhöht, sondern auch die Betriebskosten gesenkt.

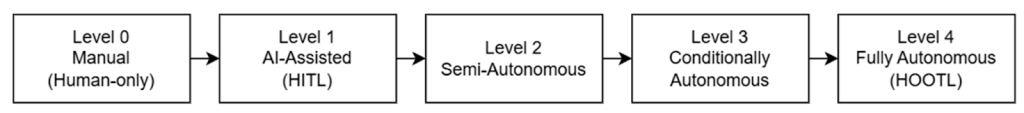

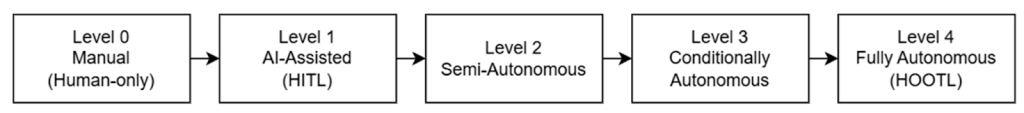

Abb. 1: Reifegrade der SOC-Automatisierung

Die Rolle von LLMs und Agenten in der Incident Response

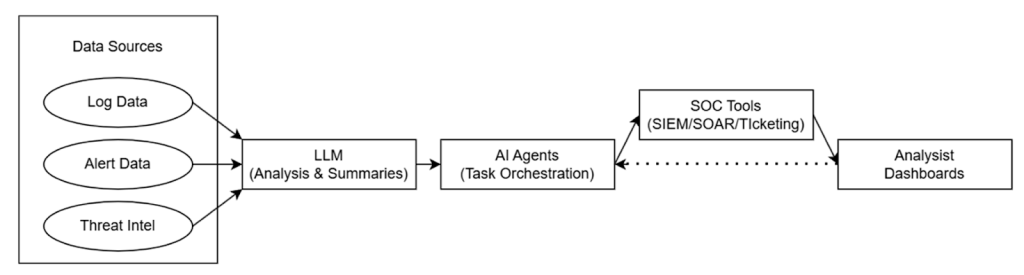

Man kann sich Large Language Models (LLMs) und autonome KI-Agenten heute als das kognitive Rückgrat unserer Verteidigung vorstellen. Während LLMs wahre Meister darin sind, sich durch Berge von unstrukturierten Sicherheitsdaten und kryptischen Logs zu wühlen, gehen autonome Agenten noch einen entscheidenden Schritt weiter: Sie übernehmen das “Denken” in komplexen, mehrstufigen Prozessen, und das fast ganz ohne menschliches Eingreifen.

Wenn es hart auf hart kommt, also bei der Incident Response, greifen sie uns an genau den richtigen Stellen unter die Arme:

- Vom Datenmüll zum Durchblick: Anstatt dass wir uns stundenlang durch Rohdaten quälen, fassen LLMs das Wichtigste in prägnanten, lesbaren Berichten zusammen.

- Agenten auf Spurensuche: Systeme wie der IRCopilot warten nicht auf Befehle, sondern koordinieren Untersuchungen eigenständig und erkennen Angriffsmuster, während sie noch entstehen.

- Smarte Entscheidungshilfe: KI-Agenten graben sich bis zur Wurzel des Problems (Root Cause Analysis) vor und servieren uns die passenden Gegenmaßnahmen direkt auf dem Silbertablett.

Abb. 2: Datenfluss in einem KI-erweiterten SOC

Technischer Deep Dive: Welches Modell für welche Aufgabe?

Die Wahl des richtigen Modells ist entscheidend für die Effektivität der Abwehr. Die Forschung zeigt, dass verschiedene Architekturen spezifische Stärken haben:

1. Random Forest (RF) & Decision Trees:

Diese Modelle sind die “Präzisions-Experten” und eignen sich hervorragend für die regelbasierte Anomalieerkennung. Sie sind extrem stark darin, bösartige Aktivitäten mit sehr hoher Genauigkeit herauszufiltern, solange die Regeln klar definierbar sind.

2. Convolutional Neural Networks (CNN):

Sie können als “Muster-Detektiv” betrachtet werden und sind besonders effektiv darin, komplexe Angriffsmuster in Zeitreihen und Log-Daten zu erkennen. Sie “sehen” also Angriffsmuster, die für menschliche Analysten im Rauschen untergehen würden.

3. Recurrent Neural Networks (RNN):

Diese kann man sich als “Gedächtnis-Künstler” vorstellen. Durch ihre Fähigkeit, sequentielle Daten zu verarbeiten, sind sie ideal, um verdächtige Verhaltensketten in Sicherheits-Logs zu identifizieren.

4. Support Vector Machines (SVM):

Diese sind weit verbreitet für Klassifizierungsaufgaben, etwa um normale Aktivitäten von potenziellen Bedrohungen abzugrenzen. Sie helfen uns also dabei, eine klare Linie zwischen “völlig normalem” Nutzerverhalten und potenziell gefährlichen Aktivitäten zu ziehen.

Abb. 3: Performance-Metriken moderner KI-Modelle

Herausforderungen & Limitationen: Zwischen Effizienz und Risiko

Trotz der Fortschritte gibt es erhebliche Risiken bei der KI-Automatisierung. Ein zentrales Problem ist die mangelnde Interpretierbarkeit von Modellen, die oft als „Black Boxes“ agieren. Wenn eine KI eine drastische Empfehlung ausspricht, der menschliche Analyst aber nicht im Ansatz nachvollziehen kann, wie das System zu diesem Schluss gekommen ist, schwindet das Vertrauen sofort.

Zudem bestehen weitere Gefahren:

• Halluzinationen: Besonders LLMs neigen dazu, Fakten extrem selbstbewusst zu erfinden. In einer kritischen Sicherheitsumgebung können solche Halluzinationen fatal sein und zu völlig falschen Reaktionen führen.

• False Positives: Inkonsistente Datenqualität kann dazu führen, dass harmlose Aktivitäten fälschlicherweise als Bedrohung eingestuft werden.

• Adversarial Attacks: Angreifer können gezielt versuchen, die KI-Modelle durch manipulierten Input zu täuschen.

Fazit: Die Zukunft der Cyberabwehr

Eines ist klar: Die Zukunft der Cybersicherheit liegt nicht darin, den Menschen durch eine Maschine zu ersetzen. Vielmehr geht es um eine adaptive Mensch-KI-Kollaboration. Wir verabschieden uns gerade von rein reaktiven „Feuerlösch-Methoden“ und bewegen uns zu einer proaktiven Verteidigung. In einem ausgereiften SOC der Zukunft wird die KI den Rücken freihalten, indem sie Routineaufgaben völlig autonom bewältigt. Das gibt uns Menschen die Freiheit, uns endlich wieder auf das Wesentliche zu konzentrieren: strategische Überwachung und die wirklich komplexen Bedrohungsszenarien.

Literaturverzeichnis

[1] AI-Augmented SOC (2025): Ein umfassender Survey über den Einsatz von LLMs und autonomen Agenten in der Sicherheitsautomatisierung.

[2] KI-Cybersicherheit Evaluation (2025): Systematische Überprüfung und Modellbewertung (CNN, RNN, RF) für eine verbesserte Bedrohungserkennung.

Leave a Reply

You must be logged in to post a comment.