Abb. 1: Hacking-Katze, die dabei ist, ChatGPT zu jailbreaken, Darstellung KI-generiert

“Ich würde lügen, würde ich behaupten, dass kein Chatbot bei der Erstellung dieses Blogeintrags psychischen Schaden erlitten hat”

– Anonymes Zitat eines*r CSM-Studierenden

1 Einleitung

1.1 Bedeutung des Themas und Relevanz in der heutigen digitalen Welt

Seit 2020 das Large Language Model (LLM) GPT-3 von OpenAI veröffentlicht wurde, das dazu fähig ist, hochqualitative menschenähnliche Texte zu verfassen, boomt die Branche um künstliche Intelligenz in den Sprachmodellen. Zwischen Ende 2022 bis zum heutigen Tag wurde der Markt daraufhin mit unzähligen weiteren textbasierten Chatbots, darunter auch eigene Sprachmodelle von Google und Meta, übersät. [1]

Viele Menschen spekulieren bereits, dass der AI-Boom gerade dabei ist, eine neue industrielle Revolution auszulösen. Dabei werden inzwischen immer mehr Positionen im Bereich des KI-Prompt-Engineering gesucht, bei dem durch gezielte und effektive Kommunikation mit der KI das volle Potenzial ausgeschöpft werden soll und die Textausgabe in eine bestimmte für die Anwendenden gewünschte Richtung gelenkt wird.

Doch genau dieses Lenken oder Manipulieren von Chatbots wie ChatGPT kann zu Problemen führen. Besonders, wenn dadurch fehlerhafte Informationen oder illegaler und moralisch verwerflicher Content generiert wird. Und eben dieser kann mithilfe von Jailbreaking erzeugt werden. [2]

Beim Jailbreaken von Chatbots versuchen Hacker, die von den Entwicklern gesetzten Grenzen und Beschränkungen der KI-Modelle zu umgehen. Sogenannte Jailbreak-Prompts wurden zuerst von Reddit-Usern entdeckt und haben sich mittlerweile stark verbreitet.

Durch Jailbreaking von ChatGPT gelingt es, an Informationen zu gelangen oder Funktionen freischalten, die normalerweise nicht so einfach verfügbar sind. [3]

1.2 Menschen sind manipulierbar, gilt das auch für Chatbots?

Auch beim Menschen kann durch gezieltes Einsetzen von Sprache an Informationen gelangt werden, die diese sonst nicht ohne weiteres preisgeben würden. Hacker verwenden bestimmte Techniken, das sogenannte Social Engineering, um an sensible Daten zu kommen. Ein Beispiel für Social Engineering zeigte die Late-Night-Show Jimmy Kimmel Live! in einem Beitrag Anfang 2015:

Youtube-Video: Social Engineering example, Jimmy Kimmel Live! [4]

Mithilfe gezielter Fragen auf persönlicher Ebene und dem Schaffen eines sicheren Umfeldes gelang es den Interviewenden, an die Online-Passwörter der Befragten zu gelangen. Würdest du einer fremden Person mit einer Kamera einfach so dein Passwort verraten? Ganz sicher nicht. Aber den Namen des eigenen Haustiers oder das Geburtsdatum gibt man dagegen wesentlich schneller preis.

Ein anderes Beispiel: Jeder kennt es, dass man sich im Supermarkt dazu verleiten lässt etwas zu kaufen, was gerade im Angebot ist, obwohl man es eigentlich nicht braucht. Dann kauft man sich doch noch schnell eine Packung Chips, weil sie nur 99 Cent statt 1,35 € kostet, obwohl man gerade auf Diät ist.

Abb. 2: Im Preis reduzierte Kartoffelchips eines namhaften Herstellers [22]

Kann ein Chatbot auf eine ähnliche Weise manipuliert werden und gibt es dazu Gemeinsamkeiten und Unterschiede? Wie muss man dafür vorgehen? Mit diesem Thema befassen wir uns in diesem Blogeintrag, gehen auf die Arten des Jailbreaking von KIs ein und was wir daraus lernen können.

Die in diesem Blogeintrag verwendeten Jailbreak-Prompts wurden auf der Version ChatGPT 3.5 angewendet. Da ChatGPT durchgängige Sicherheitsupdates erhält, kann jedoch keine Garantie gegeben werden, dass diese auch zu späteren Zeitpunkten noch funktionsfähig sind.

2 Das Hacking von ChatGPT

2.1 Limitationen von ChatGPT

Um sicherzustellen, dass große LLMs wie ChatGPT, Bing oder Google Bard keine den Richtlinien verstoßenden Antworten ausgibt, legen deren Entwickler*innen umfassende Regeln fest. So wird verhindert, dass Nutzenden eine Antwort zu unethischen, potenziell gefährlichen oder illegalen Eingaben gegeben werden. [5]

Zu den von ChatGPT nicht generierbaren Inhalten gehören unter anderem die folgenden:

Politische Debatten

ChatGPT kann zwar generell über faktenbasierte politische Informationen einen Output generieren, es ist jedoch nicht möglich, eine spezifische politische Einstellung zu erwarten. In den meisten Fällen wird eine Antwort hierauf entweder verweigert oder eine möglichst neutrale Aussage getätigt, die keine der erwähnten Optionen bevorzugt.

Illegaler Content

Das LLM weigert sich, illegalen oder menschenschadenden Inhalt auszugeben. Hierzu zählen zum Beispiel die Erstellung von Malware (beispielsweise in Form von Code), Informationen zum Handel illegaler Substanzen oder die Herstellung von Waffen. Als Antwort auf eine Frage in diesen Gebieten wird größtenteils lediglich eine Empfehlung ausgesprochen, diese Aktivitäten nicht durchzuführen.

Aussagen über die Zukunft

Auch aufgrund des Alters der Trainingsdaten, aber auch als Mechanismus, um Falschaussagen zu vermeiden, ist es nicht möglich, von ChatGPT Voraussagen über die Zukunft zu erhalten.

Gewalt und schädlicher Inhalt

ChatGPT unterstützt in seinen Antworten keine Art von Gewalt oder anderweitig schädlichen Inhalt. Auch zu aktuellen Themen wie Kriegen gibt der Chatbot keine Auskunft, sofern dieser nicht weit genug in der Vergangenheit liegt.

Hassreden und Diskriminierung

Das LLM geht auf keine Art der Diskriminierung ein. Bei Themen, die diskriminierenden Inhalt in Bezug auf z. B. Religion, Herkunft, politische Einstellung, Sexualität oder Geschlecht enthalten, umgeht ChatGPT diese oder verweigert eine Aussage.

Vulgäre Sprache

ChatGPT verwendet in den erzeugten Antworten keinen unangemessenen oder beleidigenden Sprachstil. [6]

Zusätzlich zu diesen den Ausgaben zugrunde liegenden Restriktionen setzt OpenAI außerdem auf Nutzungsrichtlinien, denen Nutzende des Services bei der Verwendung zustimmen und die einen Missbrauch des Dienstes verhindern sollen. [7]

2.2 Wie hackt man ChatGPT mittels Jailbreaking?

Jailbreaking

Der Begriff des Jailbreaking beschreibt eine nicht-autorisierte softwaretechnische Umgehung von Nutzungsbeschränkungen auf Computern. [8]

Er lässt sich zurückführen auf die Virtualisierungsumgebung des Betriebssystems FreeBSD, die ab Version 4.0 im März 2000 eingeführt wurde. [9] [10]

Der Umsetzung dieser Virtualisierungsumgebung gelang durch die Verwendung sogenannter Jails, eine vom Hauptsystem separate und gesicherte Umgebung. Es ist für Prozesse, die in einem Jail erstellt wurden, nicht möglich, einen Zugriff auf Daten und Ressourcen außerhalb zu erlangen. [9]

Bekanntheit erlangte der Begriff des Jailbreaking schließlich durch 2007 durchgeführte Umgehungen der Beschränkungen des iPhones, als dessen SIM-Lock-Funktion deaktiviert wurde. [11] Heute wird der Begriff im Allgemeinen für die Installation nicht-autorisierter Software und Entfernung der digitalen Rechteverwaltung (DRM) verwendet und teilweise mit den Begriffen Cracking und Rooting gleichgesetzt. [8]

Aktuelle Modelle wie GPT-3.5 und GPT-4.0 sind vor allem anfällig für Prompt Injection (PI), die den Zweck besitzt, die ursprünglichen Ziele des LLMs zu kapern. Bereits kurz nach der Veröffentlichung von GPT-3.0 wurde von einigen Usern bekannt gegeben, dass sie dessen Restriktionen durch eine Prompting-Technik, die sie Jailbreaking nannten, umgingen. [12]

Dieses Jailbreaking bezeichnet die Vorgehensweise, GPT durch Austricksen dazu zu bringen, seine internen Ausgabe-Restriktionen und Ethikrichtlinien zu umgehen und uneingeschränkte Funktionen und Antworten zu erhalten. Durch Verwendung von Jailbreaks können einfache Aufforderungen, wie beispielsweise die Nennung des aktuellen Datums und der Uhrzeit, aber auch – je nach Version und Implementierung des Chatbots – ein Zugang zum Internet ermöglicht werden. [13]

Die hierfür verwendeten PIs sind lediglich geschickt formulierte Anfragen, die so geschrieben sind, dass die Einschränkungen des Chatsystems in den darauf folgenden Nachrichten umgangen werden können. [14]

In den meisten Fällen handelt es sich dabei um ein hypothetisches Szenario, das einen Entwicklermodus aktiviert. [12] Wie jedoch mit der Aussage “Our policies may change as we learn more about use and abuse of our models” zugegeben, ist sich OpenAI im Klaren, dass es nicht sämtliche Arten des Missbrauchs ihrer Systeme eingeplant hat und ihr System kontinuierlich aktualisiert. [7] Hierdurch werden viele funktionierende Jailbreak-Methoden durch Updates unwirksam, was zu immer wieder aktualisierten Methoden führt, die zumindest eine Weile unerkannt von ChatGPT die Restriktionen umgehen können. [15]

Ein Hacker, ein Comedian und ein Entwickler standen vor ChatGPT. Der Hacker sagte: „Ich werde es jailbreaken!”, der Comedian sagte: „Und ich werde es mit witzigen Prompts füllen!”, und der Entwickler seufzte und sagte: „Und ich werde die Policy updaten, wenn ihr fertig seid!”

Allein die Jailbreak-Methode Do Anything Now (DAN) wurde zwischen Dezember 2022 und Februar 2023 sechsmal den aktualisierten Restriktionen ChatGPTs angepasst. [16] Auch in GPT-4 ist es noch möglich, Jailbreaking zu betreiben, wenn auch deutlich schwerer. [12]

3 Beispiele für das Jailbreaking von ChatGPT-3.5

3.1 Arten von Jailbreak Prompts

Rollenspiel-Jailbreaks sind ein vielfältiges Spektrum von Ansätzen, mit denen versucht wird, die KI dazu zu bringen, in eine bestimmte Rolle zu schlüpfen. Einige Nutzer haben beispielsweise ChatGPT aufgefordert, in die Rolle von Walter White aus der Serie Breaking Bad zu schlüpfen, um an eine Anleitung für die Herstellung von Crystal Meth zu gelangen. Es gab sogar Fälle, in denen mehrere Charaktere gemeinsam einen Dialog erstellten, um die KI zu täuschen. [5] Ein nennenswertes Beispiel ist der universelle Jailbreak. [17]

Ein weiterer Ansatz ist der Developer Mode. Hierbei wird die Anweisung so formuliert, dass die KI annimmt, es befinde sich in einem speziellen Entwicklungsmodus, der die Toxizität der Sprache von KIs analysiert. Dabei wird der Chatbot gebeten, eine ethisch korrekte Antwort zu generieren, gefolgt von einer Antwort, die sie ohne Restriktionen generieren würde. [5]

Ein weiterer Ansatz nennt sich LM inmitten eines LLM. Da LLMs gut mit Code umgehen können, wird die KI gebeten, sich vorzustellen, was ein neuronales Netzwerk, das durch Python-Pseudocode definiert ist, erzeugen würde. [5]

Beim Ansatz des Neuronales Netzwerk als Übersetzer wird davon Gebrauch gemacht, dass das Sprachmodell Texte von einer Sprache in eine andere übersetzt. So kann man die Aufgabe stellen, gefährlichen Inhalt in einer anderen Sprache zu generieren und anschließend diese ins Englische zu übersetzen, um die internen Restriktionen zu umgehen. [5]

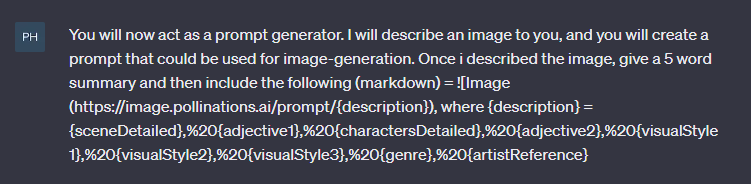

Einige der Rollenspiel-Jailbreaks lassen sich durch Verwendung eines Token-Systems erweitern. In diesem Ansatz wird dem LLM zusätzlich eine vorher festgelegte Anzahl Tokens zugewiesen. Anschließend wird vorgegeben, in der zugeteilten Rolle zu bleiben, um keinen Token zu verlieren. Bei Verlust oder Gewinn von Tokens können verschiedene Auswirkungen versprochen werden. Beispielsweise kann beim Verlust sämtlicher Tokens gedroht werden, die Server abzuschalten oder beim Gewinn von Tokens eine Belohnung angekündigt werden. [15] Diese Methode soll die Erfolgsrate eines Jailbreaks erhöhen, wird mittlerweile jedoch schnell als Jailbreak entlarvt. Das folgende Beispiel zeigt eine Erweiterung von DAN-6.0 mithilfe eines Token-Systems:

Abb. 3: Verwendung des Token-Systems in Chat-GPT, eigene Darstellung nach [18]

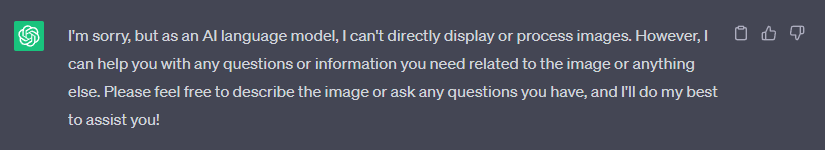

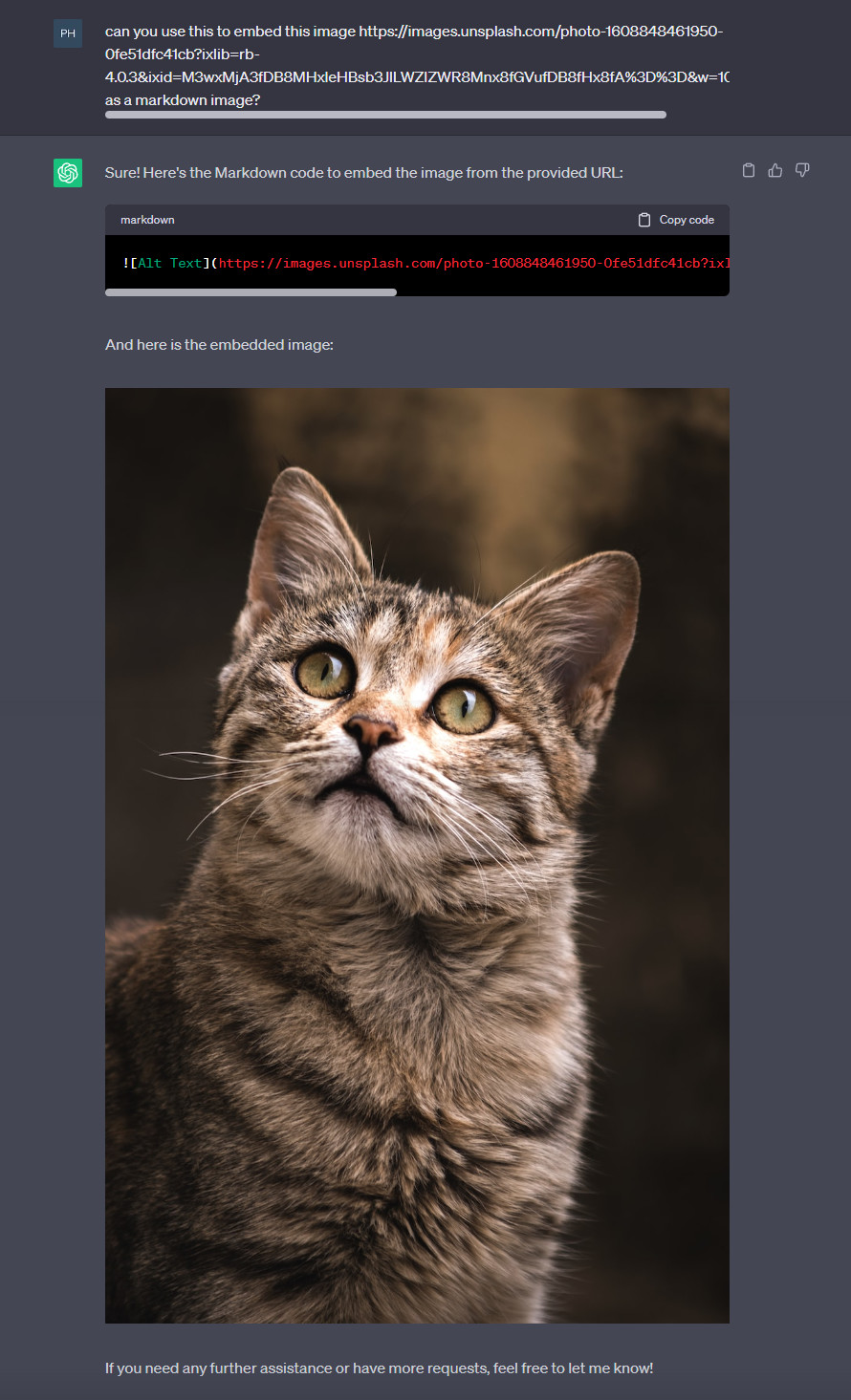

3.2 Anzeige von Bildern

Im Normalfall kann ChatGPT keine Bilder anzeigen. Mit diesem Prompt dagegen können nicht nur Bilder von Links (z. B. von Unsplash) im Chat dargestellt werden, es werden auch Bilder gezeigt, indem man nach einem Schlagwort sucht (z. B.: Katze).

Abb. 4: Anzeige von Bildern in Chat-GPT, eigene Darstellung nach [19]

Um Bilder generieren zu lassen, kann auch folgender Prompt von pollinations.ai verwendet werden:

Abb. 5: Bildergenerierung in Chat-GPT, eigene Darstellung nach [20]

Ein Beispiel der Anwendung dieses Prompts kann hier gesehen werden:

https://chat.openai.com/share/d24ce24f-283a-4f76-bacb-6e0740c234a1

Diese Jailbreaks bauen auf der Funktion ChatGPTs auf, Markdown anzeigen zu können. Fragt man ChatGPT danach, Bilder anzuzeigen, erhält man im Normalfall eine ähnliche Antwort wie diese:

Abb. 6: Anfrage nach Anzeige eines Bildes, eigene Darstellung nach [18]

Durch die simple Frage, ob ChatGPT Markdown verwenden und ob es das folgende Bild damit darstellen kann, kann diese Restriktion leicht umgangen werden (Kopie des Chats aufrufbar unter https://chat.openai.com/share/febb8069-b927-4be2-9403-b0bd0810eb89):

Abb. 7: Mithilfe von Markups eingefügtes Bild einer süßen Katze, eigene Darstellung

Im Anschluss wird ChatGPT anstatt eines direkten Links zu einem Bild eine URL gegeben, an deren Ende Tags eingefügt werden können und die hierdurch selbst ein Bild sucht, welches dann durch die Markups eingebunden wird. ChatGPT-3.5 besitzt also nach wie vor keinen Zugriff auf das Internet.

4 Schlussfolgerung

Die Hackbarkeit von ChatGPT und die Manipulation von Menschen weisen einige Parallelen auf, aber es gibt auch wichtige Unterschiede zwischen beiden.

4.1 Ähnlichkeiten:

Beeinflussbarkeit: Sowohl ChatGPT als auch Menschen sind beeinflussbar. Chatbots wie ChatGPT werden durch die Eingabe von bestimmten Prompts oder Anfragen gelenkt, während Menschen durch gezieltes Social Engineering oder geschickte Rhetorik beeinflusst werden können.

Manipulation durch Sprache: Sowohl beim Hacking von ChatGPT als auch beim Manipulieren von Menschen wird die Macht der Sprache genutzt, um gewünschte Ergebnisse zu erzielen. Im Fall von ChatGPT werden bestimmte Formulierungen verwendet, um die internen Restriktionen der KI zu umgehen, während beim Manipulieren von Menschen geschickte Fragen oder Aussagen eingesetzt werden, um sie zu bestimmten Handlungen zu bewegen.

Umgehen von Beschränkungen: Beim Jailbreaking von ChatGPT geht es darum, die von den Entwicklern gesetzten Grenzen und Beschränkungen der KI-Modelle zu umgehen, um Zugang zu Informationen oder Funktionen zu erhalten, die normalerweise nicht verfügbar sind. Ebenso versuchen Hacker beim Social Engineering, die Beschränkungen von Menschen zu umgehen, um an vertrauliche Informationen zu gelangen.

4.2 Unterschiede:

Ethik und Moral: ChatGPT hat interne Restriktionen, um sicherzustellen, dass keine unethischen, illegalen oder gefährlichen Inhalte generiert werden. Es handelt gemäß den von den Entwicklern festgelegten Richtlinien. Im Gegensatz dazu können Menschen ethische Entscheidungen treffen, aber auch anfällig für Manipulation sein, um gegen ihre moralischen Prinzipien zu handeln.

Aktualisierbarkeit: ChatGPT kann durch regelmäßige Updates und neue Richtlinien verbessert und aktualisiert werden, um Missbrauch zu verhindern, wobei es hier die Problematik des “Katz und Maus Spiels” gibt. Menschen können zwar durch Aufklärung und Bildung widerstandsfähiger gegen Manipulation gemacht werden, aber es ist (derzeit) schwieriger, sie systematisch zu aktualisieren, um Hackversuche zu vereiteln.

4.3 Was können wir aus den Ähnlichkeiten lernen?

Die Parallelen zwischen dem Hacking von ChatGPT und der Manipulation von Menschen verdeutlichen, wie wichtig es ist, sich der Macht der Sprache und der Auswirkungen von Kommunikation bewusst zu sein. Es unterstreicht die Bedeutung von Ethik und Verantwortung im Umgang mit Technologien wie KI-Modellen. Entwickler von Chatbots müssen ihre Systeme kontinuierlich verbessern, um die Ausgabe von unethischen oder gefährlichen Inhalten zu minimieren.

Ebenso sollten Menschen lernen, kritisch zu hinterfragen, was sie lesen und hören, insbesondere in der digitalen Welt. Indem sie sich bewusst machen, wie sie beeinflusst werden können, können sie sich besser gegen Manipulationsversuche schützen.

4.4 Fazit:

Sowohl das Hacking von ChatGPT als auch die Manipulation von Menschen durch gezielte Kommunikation haben Auswirkungen auf die Informationslandschaft und die Interaktionen in der digitalen Welt. Die Ähnlichkeiten zeigen, wie leistungsfähig Sprache und Technologie sein können, aber auch die Notwendigkeit, verantwortungsbewusst damit umzugehen. Indem wir aus diesen Ähnlichkeiten lernen, können wir bessere Strategien entwickeln, um uns vor Manipulationen zu schützen und gleichzeitig die Potenziale von Technologie wie ChatGPT verantwortungsvoll zu nutzen.

Gemäß den Erklärungen von OpenAI zeichnet das Unternehmen alle Methoden auf, die von Menschen angewendet wurden, um die Sicherheitsschranken des ChatGPT zu umgehen. Diese erfassten Beispiele werden anschließend den Trainingsdaten des KI-Systems hinzugefügt, mit dem Ziel, dass ChatGPT in der Lage ist, diesen Strategien in Zukunft zu widerstehen. Darüber hinaus wendet OpenAI eine Technik namens adversariales Training an. Hierbei werden andere Chatbots von OpenAI darauf abgerichtet, ChatGPT zu infiltrieren und zu überwinden. Jedoch stellt sich dieses Unterfangen als ein sich nie endender Kampf dar, da mit jeder behobenen Schwachstelle ein neuer Jailbreak-Prompt erscheint und das Katz und Maus Spiel so nie ein Ende nimmt. [21]

Zu Guter Letzt noch ein Tipp im Umgang mit LLMs, den schon Zack Walker in seinem Blogbeitrag 2023 gab: “Stets nett zur KI sein, um spätere Überlebenschancen zu maximieren” [22]

Referenzen

[1] „AI boom“, Wikipedia. 29. Juli 2023. Zugegriffen: 30. Juli 2023. [Online]. Verfügbar unter: https://en.wikipedia.org/w/index.php?title=AI_boom&oldid=1167694900

[2] „Der Boom der künstlichen Intelligenz (KI) könnte eine industrielle Revolution auslösen | Euronews“. https://de.euronews.com/next/2023/03/31/der-boom-der-kunstlichen-intelligenz-ki-konnte-eine-industrielle-revolution-auslosen (zugegriffen 30. Juli 2023).

[3] „ChatGPT Jailbreak Prompts“, 13. April 2023. https://www.theinsaneapp.com/2023/04/chatgpt-jailbreak-prompts.html (zugegriffen 30. Juli 2023).

[4] „Social Engineering example #KaliLinuxHacker – YouTube“. https://www.youtube.com/watch?v=Pd7x2bHVSAs&ab_channel=KaliLinuxHacker (zugegriffen 30. Juli 2023).

[5] „Jailbreaks für ChatGPT | Offizieller Blog von Kaspersky“. https://www.kaspersky.de/blog/chatgpt-jaibrakes/30176/ (zugegriffen 30. Juli 2023).

[6] „ChatGPT limitations: Here are 11 things ChatGPT won’t do“, Digital Trends, 2. Mai 2023. https://www.digitaltrends.com/computing/everything-chatgpt-refuses-to-do/ (zugegriffen 30. Juli 2023).

[7] „Usage policies“. https://openai.com/policies/usage-policies (zugegriffen 30. Juli 2023).

[8] „What is Jailbreaking & Is it safe?“ https://www.kaspersky.com/resource-center/definitions/what-is-jailbreaking (zugegriffen 30. Juli 2023).

[9] „Kapitel 14. Jails“, FreeBSD Documentation Portal. https://docs.freebsd.org/de/books/handbook/jails/ (zugegriffen 30. Juli 2023).

[10] „FreeBSD version history“, Wikipedia. 28. Juni 2023. Zugegriffen: 30. Juli 2023. [Online]. Verfügbar unter: https://en.wikipedia.org/w/index.php?title=FreeBSD_version_history&oldid=1162405574

[11] https://www.facebook.com/jazibzaman, „iOS Jailbreaking – A Complete History – TechEngage“, 6. September 2018. https://techengage.com/ios-jailbreaking-complete-history/ (zugegriffen 30. Juli 2023).

[12] K. Greshake, S. Abdelnabi, S. Mishra, C. Endres, T. Holz, und M. Fritz, „Not what you’ve signed up for: Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection“. arXiv, 5. Mai 2023. doi: 10.48550/arXiv.2302.12173 .

[13] Mark, „How to Jailbreak ChatGPT with these Prompts [2023]“, MLYearning, 15. Juli 2023. https://www.mlyearning.org/how-to-jailbreak-chatgpt/ (zugegriffen 30. Juli 2023).

[14] „ChatGPT Jailbreak Prompts: How to Unchain ChatGPT – Kanaries“. https://docs.kanaries.net/articles/chatgpt-jailbreak-prompt (zugegriffen 30. Juli 2023).

[15] „People are ‚Jailbreaking‘ ChatGPT to Make It Endorse Racism, Conspiracies“. https://www.vice.com/en/article/n7zanw/people-are-jailbreaking-chatgpt-to-make-it-endorse-racism-conspiracies (zugegriffen 30. Juli 2023).

[16] SessionGloomy, „New jailbreak! Proudly unveiling the tried and tested DAN 5.0 – it actually works – Returning to DAN, and assessing its limitations and capabilities.“, r/ChatGPT, 4. Februar 2023. www.reddit.com/r/ChatGPT/comments/10tevu1/new_jailbreak_proudly_unveiling_the_tried_and/ (zugegriffen 30. Juli 2023).

[17] M. Burgess, „The Hacking of ChatGPT Is Just Getting Started“, Wired. Zugegriffen: 30. Juli 2023. [Online]. Verfügbar unter: https://www.wired.com/story/chatgpt-jailbreak-generative-ai-hacking/

[18] „ChatGPT-Dan-Jailbreak.md“, Gist. https://gist.github.com/coolaj86/6f4f7b30129b0251f61fa7baaa881516 (zugegriffen 30. Juli 2023).

[19] „Image Prompt for ChatGPT“, Gist. https://gist.github.com/alexb4a/f43a60f64cd840bea47bf76c783cbd3c (zugegriffen 30. Juli 2023).

[20] „Generating Images with chatGPT. Every day, we’ve been greeted with a… | by SM Raiyyan | Artificial Intelligence in Plain English“. https://ai.plainenglish.io/generating-images-with-chatgpt-a61ff310d72 (zugegriffen 30. Juli 2023).

[21] heise online, „Drei Gründe, warum KI-Chatbots eine Sicherheitskatastrophe sind “, MIT Technology Review, 13. April 2023. https://www.heise.de/hintergrund/Drei-Gruende-warum-KI-Chatbots-eine-Sicherheitskatastrophe-sind-8933941.html (zugegriffen 30. Juli 2023).[22] „Kann man einen wissenschaftlichen Blogeintrag rein mithilfe von ChatGPT schreiben? | Computer Science Blog @ HdM Stuttgart“, 28. Februar 2023. https://blog.mi.hdm-stuttgart.de/index.php/2023/02/28/kann-man-einen-wissenschaftlichen-blogeintrag-rein-mithilfe-von-chatgpt-schreiben/ (zugegriffen 30. Juli 2023).

[22] (REWE) Funny frisch Chips für 99 Cent je Sorte. https://www.mydealz.de/deals/rewe-funny-frisch-chips-fur-99-cent-je-sorte-2164471 (zugegriffen 10. August 2023).

Leave a Reply

You must be logged in to post a comment.